Com a chegada da inteligência artificial do Google, Bard, em solos brasileiros no último mês, quem antes recorria apenas ao ChatGPT agora parece ter mais um descomplicador à disposição na hora de tirar certas dúvidas de português. Mas será que, quando o assunto são as famosas regrinhas da nossa língua, dá mesmo para confiar nessas tecnologias cada vez mais populares em todo o mundo? Ou melhor, entre ambas, qual seria a mais eficaz para revisar nossos textos e atividades?

- Siga o tecflow no Google News!

- Participe do nosso grupo no Telegram ou Whatsapp!

- Confira nossos stories no Instagram e veja notícias como essa!

- Siga o tecflow no Google Podcast e Spotify Podcast para ouvir nosso conteúdo!

- Anuncie conosco aqui.

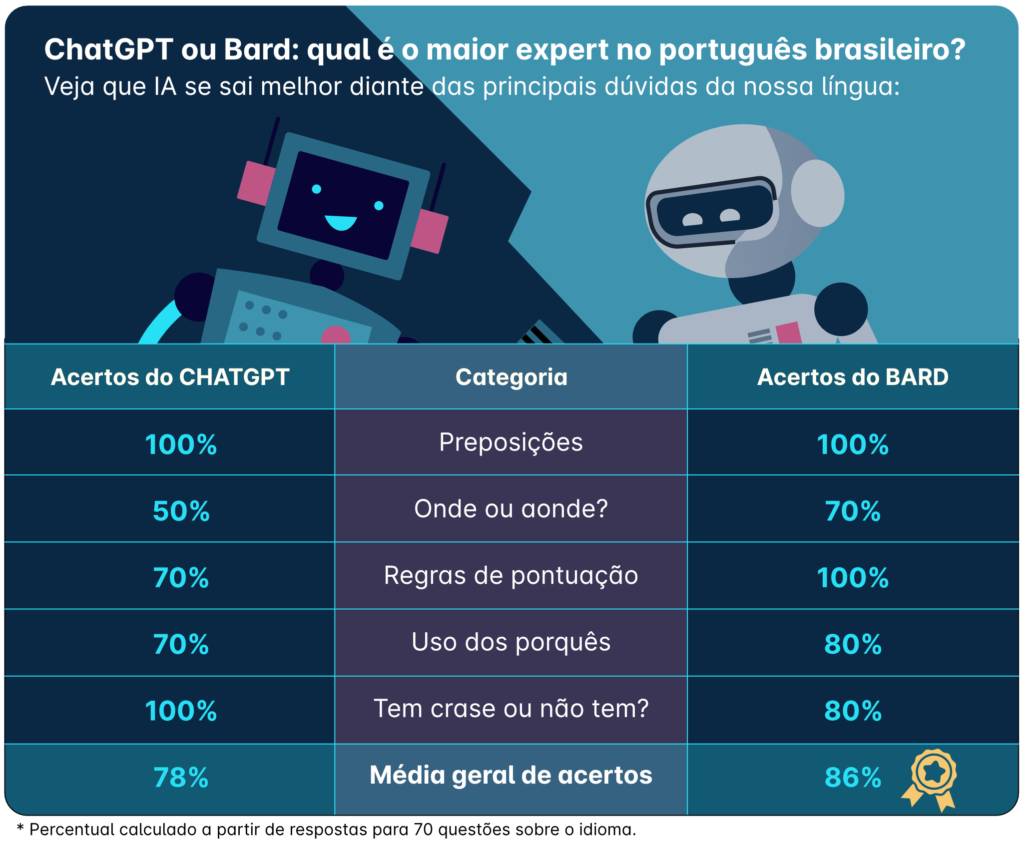

Quem traz a resposta é a Preply, que fez o teste e já adianta: das preposições aos erros de pontuação, o Bard se sai melhor que o concorrente.

Isso porque, para checar o conhecimento dos dois chatbots em relação ao português brasileiro, recentemente, a plataforma de idiomas solicitou que ambas as IA respondessem a 70 perguntas envolvendo os erros mais comuns entre os próprios brasileiros, passando por nuances como as crases, advérbios e o uso dos diferentes porquês. Enquanto a média geral de acertos do ChatGPT foi de 78% das respostas, o Bard chegou à marca de 86% no estudo comparativo da especialista.

“Onde ou aonde?”, “porque ou por quê?” : os erros que até a tecnologia comete

Embora, de forma geral, tanto o ChatGPT quanto o Bard tenham se mostrado eficientes diante da língua, o teste deixou claro onde estão suas limitações e dificuldades. Mesmo sendo capazes de explicar a diferença entre termos como “onde” e “aonde”, por exemplo, tal domínio do tema não se revelou totalmente na prática: de todas as sentenças envolvendo tais palavras, o ChatGPT só pôde acertar 50% das respostas, ao passo que os acertos do Bard, por sua vez, chegaram a 70%.

Vale lembrar que esse, provavelmente um dos erros mais cometidos pelos brasileiros, acontece porque tais palavrinhas são usadas em situações bastante específicas, apesar de igualmente remeterem à ideia de lugar — “onde” se referindo a localidades fixas (como em “onde você mora?”) e “aonde” aludindo a movimentos ou direções a lugares (“aonde você vai?”). Achou difícil? Não se preocupe: a inteligência artificial também.

Juntos ou separados, com acento ou sem acento, aparentemente, os nossos diversos porquês também foram motivo de certos “escorregos” por parte dos chatbots. Para a tecnologia da empresa OpenAI, isso significou apresentar respostas imprecisas para três das 10 questões a respeito do termo (inclusive afirmando não haver problemas com a frase “porquê você chegou cedo?”, por exemplo). Já pela sua concorrente, apenas dois erros foram detectados ao longo do teste.

Curiosamente, quando solicitadas explicações breves sobre o tema, não foram precisos muitos segundos até que uma resposta fosse dada pelas IA. “’Por que‘ questiona razões, ‘porque‘ introduz explicações, ‘porquê‘ é um substantivo para motivos e ‘por quê‘ é usado no final de frases interrogativas”, pontuou o próprio ChatGPT.

“Estruturas de frases complexas ou regras gramaticais pouco comuns podem ser particularmente desafiadoras para modelos de IA”, comenta Sylvia Johnson, líder de Metodologia da Preply. “A linguagem está repleta de expressões idiomáticas, metáforas e expressões coloquiais que nem sempre são fáceis de interpretar. Modelos de IA podem ter dificuldade em compreender e utilizar essas nuances da linguagem de forma correta, resultando em erros que revelam sua compreensão limitada do uso informal da linguagem.”

Regras de pontuação e outros acertos

Independente dos deslizes, não dá para negar: considerando algumas nuances específicas da nossa língua, tanto o ChatGPT como o Bard mandam tão bem quanto um especialista no português. Parece exagero? Pois saiba que esse foi o caso do eixo destinado a dúvidas envolvendo as diferentes preposições (“a”, “para”, “de”, “em”, “com”, “por”), seção onde 100% das perguntas foram gabaritadas com chave de ouro por ambas as tecnologias.

Em outras situações, no entanto, a disputa foi encerrada com apenas um vencedor, o que revela um pouco sobre as forças e fraquezas de cada IA. Um bom exemplo foram as questões sobre erros de pontuação, quesito no qual somente o Bard foi capaz de não cometer quaisquer enganos do começo ao fim.

Por outro lado, isso não fez com que o ChatGPT ficasse atrás do adversário. Afinal, ainda que tenha contado com a menor porcentagem de acertos totais do estudo, a ferramenta lançada em 2022 — e o app de crescimento mais rápido da história — foi aquela que se garantiu melhor quando indagada em relação às temidas crases.

Faça como os mais de 10.000 leitores do tecflow, clique no sino azul e tenha nossas notícias em primeira mão! Confira as melhores ofertas de celulares na loja parceira do tecflow.

Leandro Lima

Graduado em tecnologia e design gráfico, sou apaixonado pela fotografia e inovações tecnológicas. Atualmente escrevo para o Tecflow.

/i.s3.glbimg.com/v1/AUTH_08fbf48bc0524877943fe86e43087e7a/internal_photos/bs/2023/2/C/K25HmASUCavf2udDFn8g/bard1.jpeg)